Репликация и масштабирование

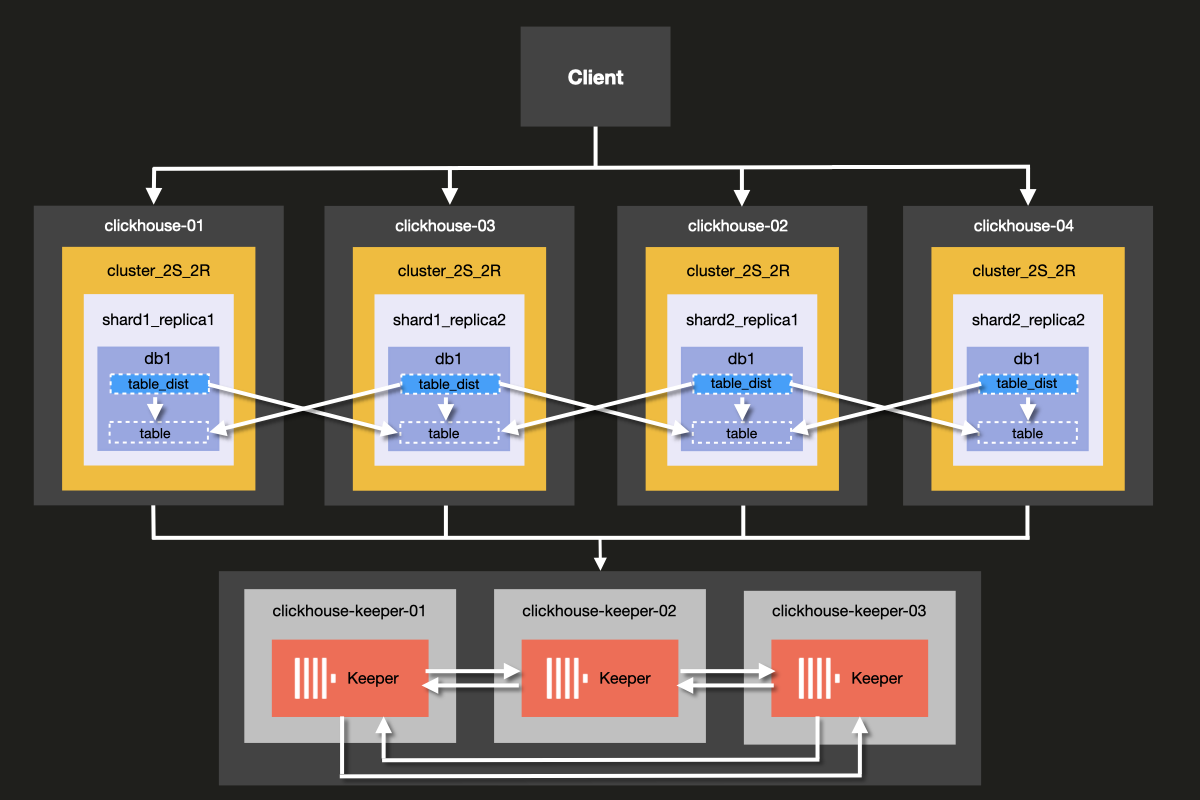

В этом примере вы узнаете, как развернуть простой кластер ClickHouse, который одновременно обеспечивает репликацию и масштабирование. Он состоит из двух шардов и двух реплик, а также кластера ClickHouse Keeper из 3 узлов для координации работы и поддержания кворума в кластере.

Архитектура кластера, который вы будете настраивать, показана ниже:

Although it is possible to run ClickHouse Server and ClickHouse Keeper combined on the same server, we strongly recommend using dedicated hosts for ClickHouse keeper in production environments, which is the approach we will demonstrate in this example.

Keeper servers can be smaller, and 4GB RAM is generally enough for each Keeper server until your ClickHouse Servers grow large.

Предварительные требования

- Вы уже развернули локальный сервер ClickHouse

- Вы знакомы с базовыми концепциями конфигурирования ClickHouse, такими как конфигурационные файлы

- На вашей машине установлен Docker

Настройка структуры каталогов и тестовой среды

The following steps will walk you through setting up the cluster from scratch. If you prefer to skip these steps and jump straight to running the cluster, you can obtain the example files from the examples repository 'docker-compose-recipes' directory.

В этом руководстве вы будете использовать Docker Compose для развёртывания кластера ClickHouse. Эту конфигурацию можно адаптировать для работы на отдельных локальных машинах, виртуальных машинах или облачных инстансах.

Выполните следующие команды для создания структуры каталогов для этого примера:

Добавьте следующий файл docker-compose.yml в каталог clickhouse-cluster:

Создайте следующие подкаталоги и файлы:

- The

config.ddirectory contains ClickHouse server configuration fileconfig.xml, in which custom configuration for each ClickHouse node is defined. This configuration gets combined with the defaultconfig.xmlClickHouse configuration file that comes with every ClickHouse installation. - The

users.ddirectory contains user configuration fileusers.xml, in which custom configuration for users is defined. This configuration gets combined with the default ClickHouseusers.xmlconfiguration file that comes with every ClickHouse installation.

It is a best practice to make use of the config.d and users.d directories when

writing your own configuration, rather than directly modifying the default configuration

in /etc/clickhouse-server/config.xml and etc/clickhouse-server/users.xml.

The line

Ensures that the configuration sections defined in the config.d and users.d

directories override the default configuration sections defined in the default

config.xml and users.xml files.

Настройка узлов ClickHouse

Настройка сервера

Теперь измените каждый пустой файл конфигурации config.xml, расположенный по пути

fs/volumes/clickhouse-{}/etc/clickhouse-server/config.d. Строки, выделенные

ниже, должны быть изменены для каждого узла отдельно:

| Каталог | Файл |

|---|---|

fs/volumes/clickhouse-01/etc/clickhouse-server/config.d | config.xml |

fs/volumes/clickhouse-02/etc/clickhouse-server/config.d | config.xml |

fs/volumes/clickhouse-03/etc/clickhouse-server/config.d | config.xml |

fs/volumes/clickhouse-04/etc/clickhouse-server/config.d | config.xml |

Каждый раздел указанного выше конфигурационного файла подробно описан ниже.

Сеть и логирование

External communication to the network interface is enabled by activating the listen host setting. This ensures that the ClickHouse server host is reachable by other hosts:

The port for the HTTP API is set to 8123:

The TCP port for interaction by ClickHouse's native protocol between clickhouse-client

and other native ClickHouse tools, and clickhouse-server and other clickhouse-servers

is set to 9000:

Конфигурация логирования определяется в блоке <logger>. Данный пример конфигурации создаёт

отладочный лог с ротацией при достижении размера 1000M (три раза):

Дополнительную информацию о настройке логирования см. в комментариях стандартного файла конфигурации ClickHouse.

Конфигурация кластера

Конфигурация кластера задаётся в блоке <remote_servers>.

Здесь задано имя кластера cluster_2S_2R.

Блок <cluster_2S_2R></cluster_2S_2R> определяет топологию кластера

с помощью параметров <shard></shard> и <replica></replica> и служит

шаблоном для распределённых DDL-запросов — запросов, выполняемых на всём

кластере с использованием конструкции ON CLUSTER. По умолчанию распределённые DDL-запросы

разрешены, но могут быть отключены с помощью параметра allow_distributed_ddl_queries.

internal_replication установлен в true, чтобы данные записывались только на одну из реплик.

Секция <cluster_2S_2R></cluster_2S_2R> определяет топологию кластера

и служит шаблоном для распределённых DDL-запросов — запросов, выполняемых

на всех узлах кластера с помощью конструкции ON CLUSTER.

Конфигурация Keeper

Секция <ZooKeeper> указывает ClickHouse, где запущен ClickHouse Keeper (или ZooKeeper).

Поскольку используется кластер ClickHouse Keeper, необходимо указать каждый узел <node> кластера

вместе с его именем хоста и номером порта с помощью тегов <host> и <port> соответственно.

Настройка ClickHouse Keeper описана на следующем шаге руководства.

Хотя ClickHouse Keeper можно запустить на том же сервере, что и ClickHouse Server, для production-окружений мы настоятельно рекомендуем использовать выделенные хосты для ClickHouse Keeper.

Конфигурация макросов

Кроме того, секция <macros> используется для определения подстановки параметров для

реплицируемых таблиц. Они перечислены в system.macros и позволяют использовать подстановки

типа {shard} и {replica} в запросах.

Настройка пользователя

Теперь измените каждый пустой конфигурационный файл users.xml, расположенный в

fs/volumes/clickhouse-{}/etc/clickhouse-server/users.d, следующим образом:

В данном примере пользователь по умолчанию настроен без пароля для упрощения. На практике это не рекомендуется.

В данном примере файл users.xml одинаков для всех узлов кластера.

Настройка ClickHouse Keeper

Далее необходимо настроить ClickHouse Keeper, который используется для координации.

Настройка Keeper

In order for replication to work, a ClickHouse keeper cluster needs to be set up and configured. ClickHouse Keeper provides the coordination system for data replication, acting as a stand in replacement for Zookeeper, which could also be used. ClickHouse Keeper is, however, recommended, as it provides better guarantees and reliability and uses fewer resources than ZooKeeper. For high availability and to keep quorum, it is recommended to run at least three ClickHouse Keeper nodes.

ClickHouse Keeper can run on any node of the cluster alongside ClickHouse, although it is recommended to have it run on a dedicated node which allows scaling and managing the ClickHouse Keeper cluster independently of the database cluster.

Create the keeper_config.xml files for each ClickHouse Keeper node

using the following command from the root of the example folder:

Modify the empty configuration files which were created in each

node directory fs/volumes/clickhouse-keeper-{}/etc/clickhouse-keeper. The

highlighted lines below need to be changed to be specific to each node:

| Каталог | Файл |

|---|---|

fs/volumes/clickhouse-keeper-01/etc/clickhouse-keeper | keeper_config.xml |

fs/volumes/clickhouse-keeper-02/etc/clickhouse-keeper | keeper_config.xml |

fs/volumes/clickhouse-keeper-03/etc/clickhouse-keeper | keeper_config.xml |

Each configuration file will contain the following unique configuration (shown below).

The server_id used should be unique for that particular ClickHouse Keeper node

in the cluster and match the server <id> defined in the <raft_configuration> section.

tcp_port is the port used by clients of ClickHouse Keeper.

The following section is used to configure the servers that participate in the quorum for the raft consensus algorithm:

ClickHouse Cloud removes the operational burden associated with managing shards and replicas. The platform automatically handles high availability, replication, and scaling decisions. Compute and storage are separate and scale based on demand without requiring manual configuration or ongoing maintenance.

Проверка настройки

Убедитесь, что Docker запущен на вашем компьютере.

Запустите кластер командой docker-compose up из корневого каталога cluster_2S_2R:

Вы увидите, как docker начнет загружать образы ClickHouse и Keeper, а затем запустит контейнеры:

Чтобы проверить, что кластер запущен, подключитесь к любому из узлов и выполните следующий запрос. Команда для подключения к первому узлу:

При успешном подключении вы увидите командную строку клиента ClickHouse:

Выполните следующий запрос, чтобы проверить, какие топологии кластера определены для каких хостов:

Выполните следующий запрос, чтобы проверить состояние кластера ClickHouse Keeper:

The mntr command is also commonly used to verify that ClickHouse Keeper is

running and to get state information about the relationship of the three Keeper nodes.

In the configuration used in this example, there are three nodes working together.

The nodes will elect a leader, and the remaining nodes will be followers.

The mntr command gives information related to performance, and whether a particular

node is a follower or a leader.

You may need to install netcat in order to send the mntr command to Keeper.

Please see the nmap.org page for download information.

Run the command below from a shell on clickhouse-keeper-01, clickhouse-keeper-02, and

clickhouse-keeper-03 to check the status of each Keeper node. The command

for clickhouse-keeper-01 is shown below:

The response below shows an example response from a follower node:

The response below shows an example response from a leader node:

Таким образом, вы успешно настроили кластер ClickHouse с двумя шардами и двумя репликами. На следующем шаге вы создадите таблицу в кластере.

Создание базы данных

Теперь, когда вы убедились, что кластер правильно настроен и запущен, вы создадите ту же таблицу, что и в руководстве по примеру набора данных UK property prices. Она содержит около 30 миллионов записей о ценах на недвижимость в Англии и Уэльсе с 1995 года.

Подключитесь к клиенту каждого хоста, выполнив следующие команды в отдельных вкладках или окнах терминала:

Вы можете выполнить приведённый ниже запрос из clickhouse-client на каждом хосте, чтобы убедиться, что помимо стандартных баз данных других пока не создано:

Из клиента clickhouse-01 выполните следующий распределённый DDL-запрос с использованием

конструкции ON CLUSTER для создания новой базы данных uk:

Вы можете снова выполнить тот же запрос из клиента каждого хоста,

чтобы убедиться, что база данных создана во всём кластере, несмотря на то, что

запрос выполнялся только из clickhouse-01:

Создание таблицы в кластере

Теперь, когда база данных создана, создайте таблицу с репликацией.

Выполните следующий запрос из любого клиента на хосте:

Обратите внимание, что этот запрос идентичен запросу из исходной инструкции CREATE в

руководстве по примеру набора данных цен на недвижимость в Великобритании,

за исключением конструкции ON CLUSTER и использования движка ReplicatedMergeTree.

Конструкция ON CLUSTER предназначена для распределённого выполнения DDL-запросов (Data Definition Language),

таких как CREATE, DROP, ALTER и RENAME, что обеспечивает применение

изменений схемы на всех узлах кластера.

Движок ReplicatedMergeTree

работает так же, как обычный движок таблиц MergeTree, но дополнительно реплицирует данные.

Необходимо указать два параметра:

zoo_path: Путь в Keeper/ZooKeeper, по которому хранятся метаданные таблицы.replica_name: Имя реплики таблицы.

Параметр zoo_path можно задать произвольно, однако рекомендуется следовать соглашению об использовании префикса

где:

{database}и{table}будут автоматически подставлены.{shard}и{replica}— макросы, которые были определены ранее в файлеconfig.xmlкаждого узла ClickHouse.

Вы можете выполнить приведённый ниже запрос из клиента каждого хоста, чтобы убедиться, что таблица создана во всём кластере:

Вставка данных в распределённую таблицу

Для вставки данных в таблицу нельзя использовать ON CLUSTER, поскольку эта конструкция

не применяется к DML-запросам (Data Manipulation Language — язык манипулирования данными), таким как INSERT, UPDATE

и DELETE. Для вставки данных необходимо использовать

табличный движок Distributed.

Как описано в руководстве по настройке кластера с 2 шардами и 1 репликой, распределённые таблицы — это таблицы, имеющие доступ к шардам, расположенным на разных

хостах, и определяемые с помощью табличного движка Distributed.

Распределённая таблица служит интерфейсом для всех шардов в кластере.

С любого из клиентов хоста выполните следующий запрос для создания распределённой таблицы на основе существующей реплицируемой таблицы, созданной на предыдущем шаге:

На каждом хосте теперь будут доступны следующие таблицы в базе данных uk:

Данные можно вставить в таблицу uk_price_paid_distributed с любого из

клиентских хостов с помощью следующего запроса:

Выполните следующий запрос, чтобы убедиться, что вставленные данные равномерно распределены по узлам кластера:

Заключение

Преимущество такой топологии кластера с 2 шардами и 2 репликами в том, что она обеспечивает и масштабируемость, и отказоустойчивость. Данные распределяются по отдельным хостам, снижая требования к хранению и операциям ввода-вывода (I/O) на каждый узел, а запросы обрабатываются параллельно на обоих шардах, что повышает производительность и эффективность использования памяти. Важно, что кластер может выдержать потерю одного узла и продолжить обслуживать запросы без перебоев, поскольку у каждого шарда есть резервная реплика на другом узле.

Основной недостаток такой топологии кластера — увеличенные затраты на хранение: требуется в два раза больше дискового пространства по сравнению с конфигурацией без реплик, поскольку каждый шард дублируется. Кроме того, хотя кластер выдерживает отказ одного узла, одновременная потеря двух узлов может сделать кластер неработоспособным в зависимости от того, какие именно узлы выйдут из строя и как распределены шарды. Эта топология представляет собой компромисс между доступностью и стоимостью, что делает её подходящей для продакшн-сред, где требуется определённый уровень отказоустойчивости без расходов на более высокий коэффициент репликации.

Чтобы узнать, как ClickHouse Cloud обрабатывает запросы, обеспечивая и масштабируемость, и отказоустойчивость, см. раздел "Parallel Replicas".