ClickHouse Cloud

Эта функция находится в режиме закрытого предварительного просмотра в ClickHouse Cloud. Если ваша организация заинтересована в приоритетном доступе, присоединяйтесь к списку ожидания.

Если вы только начинаете работать с ClickHouse Cloud, нажмите здесь, чтобы узнать больше, или зарегистрируйтесь для бесплатной пробной версии, чтобы начать работу.

Этот вариант предназначен для пользователей ClickHouse Cloud. В этом варианте развертывания и ClickHouse, и HyperDX размещаются в ClickHouse Cloud, что минимизирует количество компонентов, которые пользователю необходимо хостить самостоятельно.

Помимо снижения объёма управления инфраструктурой, такой вариант развертывания обеспечивает интеграцию аутентификации с SSO/SAML ClickHouse Cloud. В отличие от самостоятельно развернутых инсталляций, здесь также нет необходимости поднимать экземпляр MongoDB для хранения состояния приложения — такого как дашборды, сохранённые запросы, пользовательские настройки и оповещения.

В этом режиме ингестия данных полностью остаётся на стороне пользователя. Вы можете выполнять приём данных в ClickHouse Cloud с помощью собственного развернутого коллектора OpenTelemetry, прямого приёма из клиентских библиотек, нативных табличных движков ClickHouse (таких как Kafka или S3), ETL-пайплайнов или ClickPipes — управляемого сервиса ингестии ClickHouse Cloud. Такой подход обеспечивает самый простой и высокопроизводительный способ эксплуатации ClickStack.

Подходит для

Этот паттерн развертывания оптимален в следующих сценариях:

- У вас уже есть данные наблюдаемости в ClickHouse Cloud, и вы хотите визуализировать их с помощью HyperDX.

- Вы управляете крупным развертыванием системы наблюдаемости и нуждаетесь в выделенной производительности и масштабируемости ClickStack в связке с ClickHouse Cloud.

- Вы уже используете ClickHouse Cloud для аналитики и хотите инструментировать свое приложение с помощью библиотек инструментирования ClickStack, отправляя данные в тот же кластер. В этом случае мы рекомендуем использовать warehouses для изоляции вычислительных ресурсов под рабочие нагрузки наблюдаемости.

Шаги по развертыванию

В этом руководстве предполагается, что у вас уже создан сервис ClickHouse Cloud. Если вы ещё не создали сервис, выполните шаг "Создать сервис ClickHouse" из нашего руководства по быстрому старту.

Копирование учетных данных службы (необязательно)

Если у вас уже есть события наблюдаемости, которые требуется визуализировать в вашем сервисе, этот шаг можно пропустить.

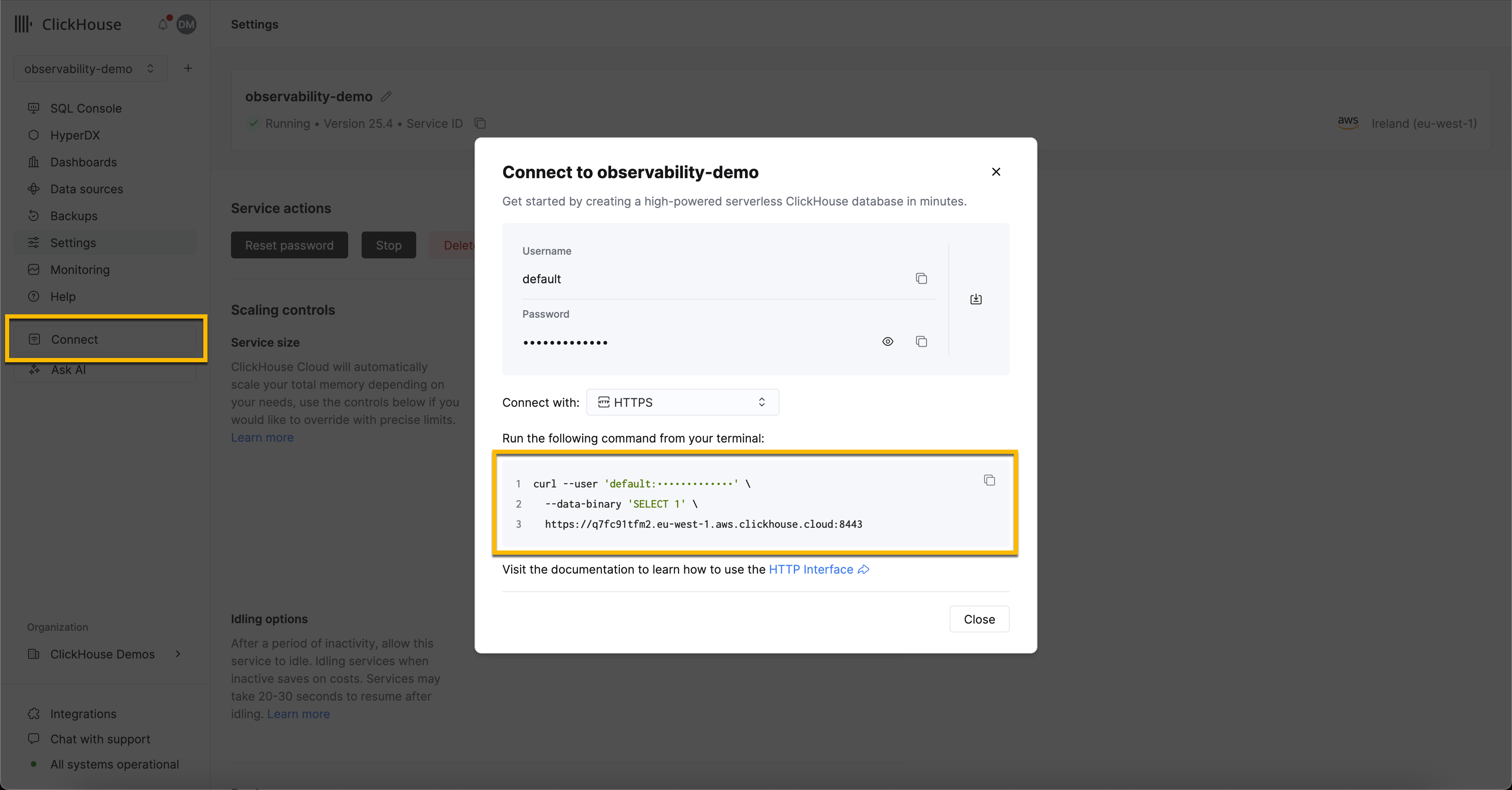

Перейдите к основному списку сервисов и выберите сервис, события наблюдаемости которого вы хотите визуализировать в HyperDX.

Нажмите кнопку Connect в меню навигации. Откроется модальное окно с учетными данными для подключения к вашему сервису и инструкциями по подключению через различные интерфейсы и языки программирования. Выберите HTTPS из выпадающего списка и сохраните адрес конечной точки подключения и учетные данные.

Развертывание OpenTelemetry Collector (необязательно)

Если у вас уже есть события наблюдаемости, которые требуется визуализировать в вашем сервисе, этот шаг можно пропустить.

Этот шаг обеспечивает создание таблиц со схемой OpenTelemetry (OTel), которая в дальнейшем может быть использована для создания источника данных в HyperDX. Также предоставляется конечная точка OLTP для загрузки примеров наборов данных и отправки событий OTel в ClickStack.

В следующих инструкциях используется стандартный дистрибутив OTel collector, а не дистрибутив ClickStack. Последний требует OpAMP-сервер для конфигурации. В настоящее время это не поддерживается в закрытой предварительной версии. Приведенная ниже конфигурация воспроизводит версию, используемую дистрибутивом ClickStack для коллектора, предоставляя OTLP-эндпоинт, на который могут отправляться события.

Загрузите конфигурацию для OTel collector:

otel-cloud-config.yaml

Разверните коллектор с помощью следующей команды Docker, указав соответствующие переменные окружения со значениями параметров подключения, зафиксированными ранее, и выбрав подходящую команду ниже в зависимости от вашей операционной системы.

В производственной среде рекомендуется создать выделенного пользователя для ингестии, ограничив права доступа к необходимым базе данных и таблицам. Подробности см. в разделе "База данных и пользователь для ингестии".

Подключение к HyperDX

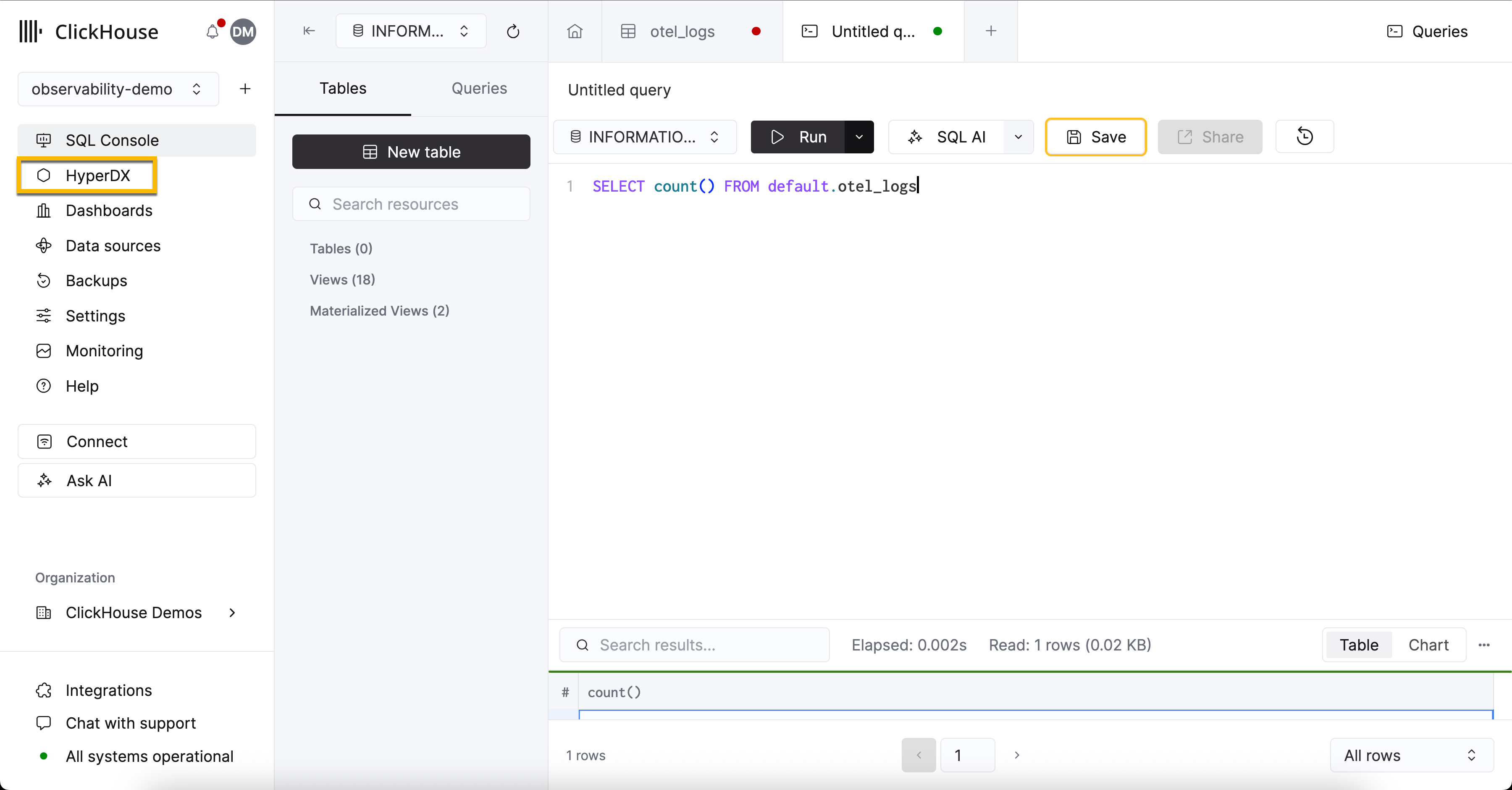

Выберите нужный сервис, затем выберите HyperDX в меню слева.

Создавать пользователя не потребуется — вы будете автоматически аутентифицированы, после чего система предложит создать источник данных.

Пользователям, которые хотят только изучить интерфейс HyperDX, мы рекомендуем наши примеры наборов данных, использующие данные OTel.

Разрешения пользователя

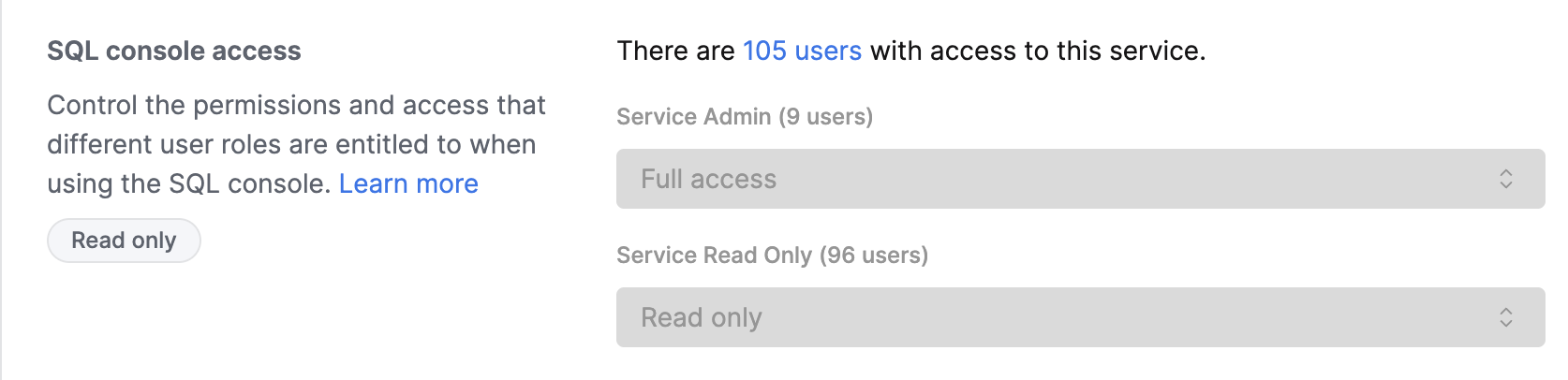

Пользователи, получающие доступ к HyperDX, автоматически проходят аутентификацию с помощью учётных данных консоли ClickHouse Cloud. Управление доступом осуществляется через разрешения SQL-консоли, настроенные в параметрах сервиса.

Настройка доступа пользователей

- Перейдите к своему сервису в консоли ClickHouse Cloud

- Перейдите в раздел Settings → SQL Console Access

- Установите соответствующий уровень прав доступа для каждого пользователя:

- Service Admin → Full Access - Необходимо для включения оповещений

- Service Read Only → Read Only - Позволяет просматривать данные наблюдаемости и создавать дашборды

- No access - Не имеет доступа к HyperDX

Чтобы включить оповещения, хотя бы один пользователь с правами Service Admin (соответствует Full Access в выпадающем списке SQL Console Access) должен войти в HyperDX как минимум один раз. Это создаст выделенную учётную запись в базе данных для выполнения запросов оповещений.

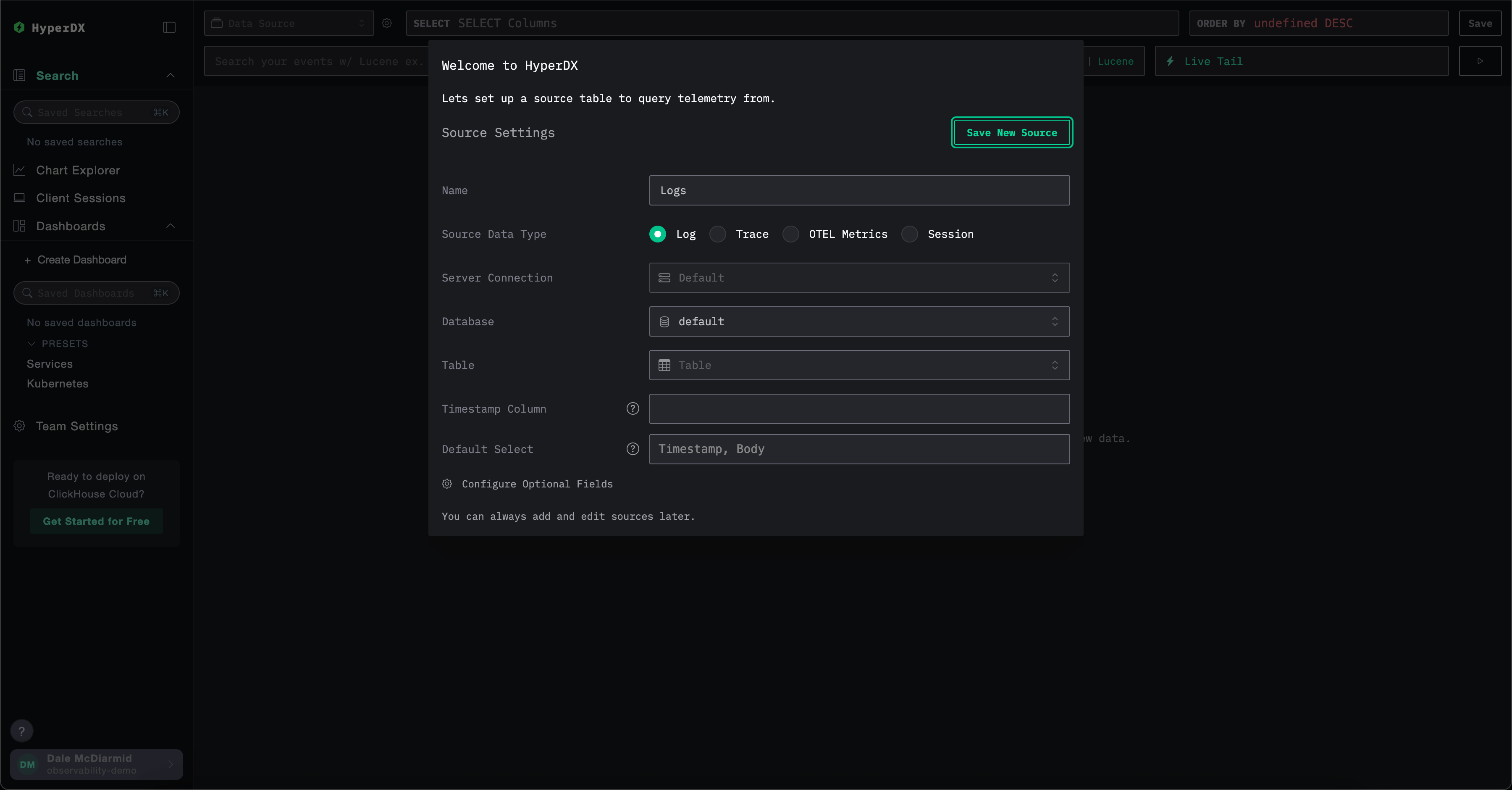

Создание источника данных

HyperDX изначально поддерживает OpenTelemetry, но не ограничивается им — пользователи могут использовать собственные схемы таблиц при необходимости.

Использование схем OpenTelemetry

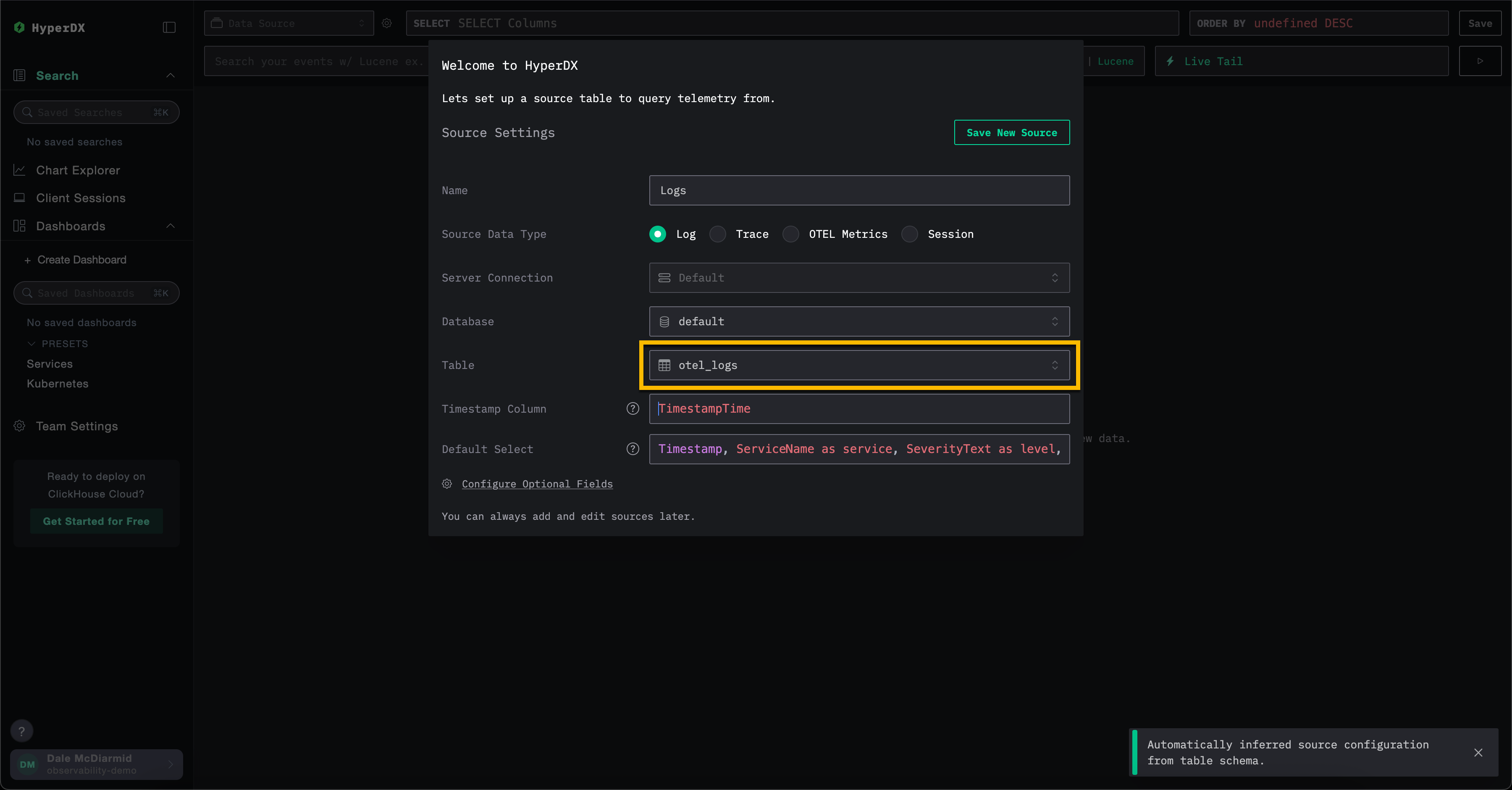

Если вы используете указанный выше OTel collector для создания базы данных и таблиц в ClickHouse, оставьте все значения по умолчанию в форме создания источника, указав в поле Table значение otel_logs — это создаст источник логов. Все остальные параметры должны определиться автоматически, после чего можно нажать Save New Source.

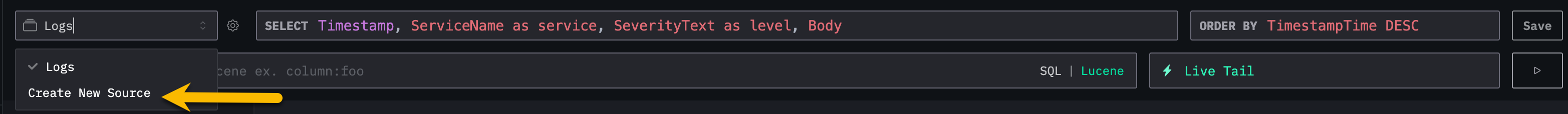

Для создания источников трассировок и метрик OTel выберите Создать Новый Источник в верхнем меню.

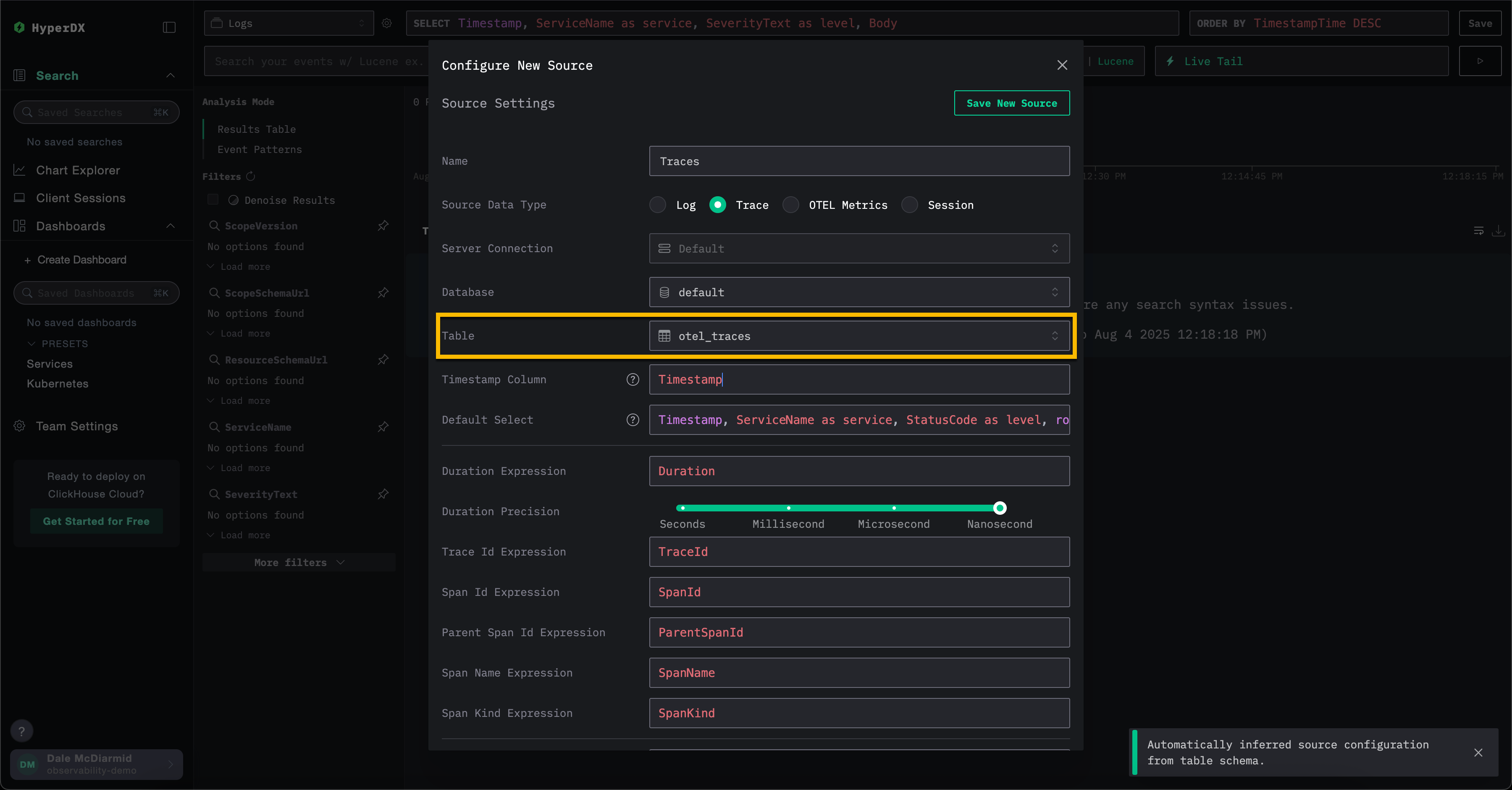

Здесь выберите требуемый тип источника, затем соответствующую таблицу — например, для трассировок выберите таблицу otel_traces. Все настройки должны определиться автоматически.

Обратите внимание, что различные источники данных в ClickStack — такие как логи и трассировки — можно коррелировать между собой. Для этого требуется дополнительная настройка каждого источника. Например, в источнике логов можно указать соответствующий источник трассировок и наоборот. Подробнее см. раздел "Коррелированные источники".

Использование пользовательских схем

Пользователи, которые хотят подключить HyperDX к существующему сервису с данными, могут настроить параметры базы данных и таблиц в соответствии с требованиями. Настройки будут определены автоматически, если таблицы соответствуют схемам OpenTelemetry для ClickHouse.

При использовании собственной схемы рекомендуется создать источник логов с указанием всех необходимых полей — подробнее см. в разделе "Настройки источника логов".

JSON type support

JSON type support in ClickStack is a beta feature. While the JSON type itself is production-ready in ClickHouse 25.3+, its integration within ClickStack is still under active development and may have limitations, change in the future, or contain bugs.

ClickStack has beta support for the JSON type from version 2.0.4.

For the benefits of this type see Benefits of the JSON type.

In order to enable support for the JSON type users must set the following environment variables:

OTEL_AGENT_FEATURE_GATE_ARG='--feature-gates=clickhouse.json'- enables support in the OTel collector, ensuring schemas are created using the JSON type.BETA_CH_OTEL_JSON_SCHEMA_ENABLED=true- enables support in the HyperDX application, allowing JSON data to be queried.

Кроме того, пользователям следует связаться с support@clickhouse.com, чтобы убедиться, что в их сервисе ClickHouse Cloud включена поддержка JSON.